Vous connaissez Office 365 ? Oubliez ce nom commercial, remplacé depuis 2 ans maintenant par Microsoft 365 et ses outils de collaboration. Mais au-delà du tour de passe-passe marketing dont Microsoft a le secret, ce renommage cache quelques nouveautés. Ou plutôt, des secrets que peu d’utilisateurs connaissent ou savent exploiter. Voici quelques exemples du niveau de maturité de l’outil incontournable de Microsoft.

Microsoft 365 regroupe les services de collaboration en ligne Cloud de Microsoft et les licences de la suite Office. Composé de 4 packages pour le petites entreprises, cette offre s’est fait une place de choix dans ce secteur. A tel point qu’on peut se demander si une véritable alternative existe. Mais malgré cette hégémonie sur le marché, une bonne partie de la clientèle n’utilise que les fonctions de base. Alors que ces outils recèlent quelques fonctionnalités avancées qui boostent l’efficacité des utilisateurs. Petit florilège.

Office Web : efficace et gratuit !

Le premier package de services de collaboration Microsoft 365, nommé Business Basic, ne fournit que les services en ligne. Stockage de fichiers OneDrive et SharePoint, messagerie Exchange Online et Teams sont donc disponibles, au travers d’un navigateur ou via les logiciels associés. Mais comment faire pour travailler sur ses fichiers Excel et Word sans disposer des licences correspondantes ? Et comment utiliser ses emails sans disposer d’Outlook ?

La réponse est simple : en ligne ! L’accès à la suite Office via le navigateur est en effet inclus dans ce package, au contraire des logiciels. Word, Excel et Powerpoint s’ouvrent alors dans un nouvel onglet, avec les mêmes menus que sur les applications « en dur ». Si ces versions en ligne n’étaient clairement pas recommandables il y a encore 2 ou 3 ans en arrière, les progrès réalisés, aussi bien en termes de performance que de fonctionnalités et d’ergonomie sont notables.

Et pour cause : La nouvelle version de Teams, et celle d’Outlook qui sera officialisée d’ici à la fin de l’année, utilisent la même technologie de présentation des écrans que celle du navigateur Microsoft Edge. Avec, à la clé, une expérience identique dans les deux environnements – le navigateur ou l’application lourde. Dans Teams, c’est tout aussi flagrant que bluffant. On ne fait simplement pas de différence, car il n’y en a pas.

Partage de fichiers : la fin des attachements

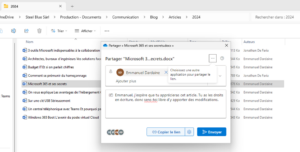

Une fois les fichiers édités depuis votre navigateur, vous aimeriez les envoyer par email évidemment. Halte ! Plutôt que d’expédier 5 fois le même fichier de 37MB à vos interlocuteurs, laissez-les venir le chercher là où il se trouve : en ligne ! Le stockage des fichiers dans le Cloud a permis de généraliser les liens de partage sur votre infrastructure.

Si Microsoft n’a rien inventé – Google fait cela depuis bien longtemps, sa maîtrise de bout en tout de l’environnement utilisateur permet de fournir une intégration optimale, et une expérience homogène. Que vous partagiez depuis un navigateur ou depuis l’explorateur de fichiers sous Windows, c’est la même fenêtre qui s’ouvre. Avec les mêmes options. Et là encore, il faut comprendre que c’est une fenêtre de navigateur qui apparaît dans les deux cas.

Si celle-ci était assez lente à charger il y a quelques mois, des améliorations ont été faites récemment. Si bien que partager un fichier directement depuis Windows juste après l’avoir édité est simple, rapide, et efficace. Entrez l’adresse email de votre destinataire, un message d’explication, et le tour est joué, d’un simple clic droit. Le tout directement depuis votre bureau Windows.

Des versions à foison

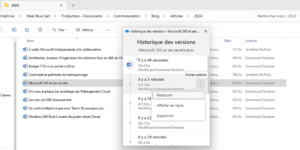

Partager c’est bien. Mais que se passe-t-il si mon correspondant modifie un fichier par erreur, voire le supprime ? Pas de panique, vous pouvez retrouver l’entier des versions de chaque fichier. Où ça ? En ligne ! Le passage à la collaboration Microsoft 365 a coïncidé avec la généralisation de la sauvegarde automatique, pourvu que vos fichiers soient au dernier format Office en cours (par exemple, .docx ou .xlsx).

Pour que cela fonctionne, vos fichiers doivent être stockés en ligne sur OneDrive et SharePoint. Si bien que dès que vous modifiez un document, les changements sont enregistrés en temps réel. Avec la possibilité de revenir en arrière sur chacune des versions majeures dudit fichier. Combien par fichier au total ? 50’000. De quoi voir venir.

L’intégration dans Windows est aussi remarquable puisque depuis l’explorateur de fichiers, vous pouvez requérir la liste des versions, en restaurer une ou en inspecter une autre en ligne sans affecter la version courante. Tout ceci depuis une petite fenêtre de navigateur parfaitement intégrée à Windows. La technologie est la même que pour les partages.

Collaboration Microsoft 365 : du « premier servi » au « travailler ensemble »

Et si jamais vous et votre correspondant décidez de modifier ce même fichier en ligne en même temps ? Le système est prévu pour cela, et intègre la modification concurrente des documents. C’est un renversement complet du paradigme qui valait jusqu’à maintenant, où le premier utilisateur à ouvrir un fichier s’octroyait les droits en écriture, alors que les autres ne pouvaient que le lire.

Avec la collaboration Microsoft 365, vous savez qui fait quoi en temps réel. En plus de voir quel utilisateur est connecté sur le fichier, vous pouvez suivre en direct les modifications apportées. C’est évidemment un plus appréciable, qui donne une nouvelle dimension à la collaboration bureautique. Et ceci fonctionne aussi bien depuis les logiciels de la suite Office qu’en ligne dans le navigateur.

Avec l’avantage de conserver le contrôle complet sur votre référentiel documentaire, puisque les fichiers ne quittent plus votre stockage Cloud. Dites au revoir aux envois et aux suivis de version par email entre utilisateurs. Ici, les utilisateurs travaillent tous sur un document unique, qui évolue au fil des versions et des modifications. Si la fonction n’est là encore pas nouvelle, c’est l’intégration dans Office et son efficacité qui changent la donne.

Ces quelques exemples ne sont évidemment que la partie émergée de l’iceberg. Microsoft 365 recèle bien d’autres secrets. Parfois surprenants, parfois déstabilisants, ils changent nos habitudes de travail. Considérant la puissance de feu de Microsoft en termes technologiques, l’adoption sera progressive, mais massive. Et il n’y aura plus retour en arrière. Alors pour bien appréhender ces changements, quoi de mieux qu’une petite formation ? Demandez-nous donc de passer vous voir pour une session de 2 heures où vous en apprendrez bien plus que vous ne le pensez.

Emmanuel Dardaine

Besoin d’une partite formation pour mieux utiliser Microsoft 365 ? Contactez-nous !