« Patience et longueur de temps » est certainement la devise de Microsoft. Car si le géant américain dispose de moyens sans limite, Rome ne peut pas toujours se faire en un jour. Il faut parfois laisser le marché maturer. Et plutôt utiliser ses ressources marketing et techniques pour se placer en position de force. Afin de dégainer le moment venu. Un exemple ? Utiliser Teams pour basculer la téléphonie d’entreprise des PME…

Il y a plus ou moins 5 années en arrière, le monde découvrait le Covid-19. Et une période d’incertitude comme l’histoire récente n’en avait pas connue s’ouvrait devant nous. Mais le grand public découvrait aussi par la même occasion Teams, l’outil de collaboration de Microsoft. Ce produit, issu du rachat de Skype for Business quelques années plus tôt, aura permis, entre autres, au monde professionnel de continuer à travailler. Et accessoirement aux particuliers d’organiser des soirées virtuelles.

Un peu d’histoire

Si cette émergence peut paraître anecdotique, il est utile de rappeler que Teams n’avait été lancé officiellement qu’en 2016, et qu’il remplaçait tout aussi officiellement Skype for Business en 2017. Soit environ 2 années avant que la pandémie ne frappe à notre porte. Si ces échelles de temps sont relativement longues dans le monde informatique, il en va autrement quand il s’agit d’imposer à un produit à l’échelle mondiale. Avec le recul, on peut dire que la percée de Teams a été rapide. Très rapide.

A peu près à la même époque, Teams avait été déclaré apte à traiter les appels téléphoniques. Après tout, quoi de plus normal : l’outil était capable, comme ses concurrents, de gérer des appels audio et vidéo sur Internet, entre plusieurs participants. Ajouter des fonctions de téléphone revenait à s’interfacer avec le réseau téléphonique public, que ce soit pour passer ou recevoir des appels. Ou autrement dit, il suffisait de faire le pont entre deux technologies existantes.

Si le service a eu peu de succès au début, les choses se sont accélérées depuis deux ou trois ans. Il faut dire que la qualité n’était pas forcément au rendez-vous pour les premiers clients à opter pour ce service. Et la difficulté apparente de porter ses numéros d’entreprise n’aidait pas non plus : Microsoft préférait proposer ses propres numéros, ce qui ne fait pas de sens pour une PME. Dernier écueil : les tarifs des communications n’étaient pas attractifs. Alors comment expliquer un tel revirement ?

Teams, ou la téléphonie d’entreprise réinventée

Ce sont les opérateurs téléphoniques eux-mêmes qui ont donné ses lettres de noblesse à Teams Phone. Tout autant attirés par un nouveau marché que par la crainte de voir leurs clients existants fuir vers d’autres horizons. Ils ont donc poussé progressivement cette alternative vers leur clientèle, afin de ne pas se faire déborder par une nouvelle concurrence. Quitte à y laisser quelques plumes : déplacer la téléphonie d’entreprise sur Teams revenait à abandonner la gestion de ce service à l’IT. Et à être réduit à faire le passe-plat des minutes de communication.

Car le marché de la téléphonie fixe professionnelle a toujours été très lucratif. Que ce soit pour les électriciens, qui ont longtemps sélectionné et installé le matériel sur site. Quitte à faire payer extrêmement cher le moindre changement de configuration. Ou pour les opérateurs, qui avaient développé des centraux téléphoniques virtuels dans le Cloud, regroupant ainsi les appels et l’intelligence dans leurs centres de données en remplacement des équipements déployés habituellement chez les clients.

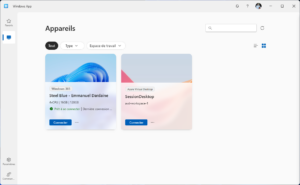

Les clients eux-mêmes n’ont pas été étrangers à cette transition. Avec l’avènement de Teams en entreprise, ils ont progressivement exprimé le besoin de traiter leurs appels avec un outil de communication qu’ils connaissaient bien. Et surtout, avec un outil disponible sur une multitude d’appareil. A la clé : de la flexibilité pour les utilisateurs, qui pouvaient appliquer à la téléphonie le choix de leur appareil préféré (smartphone, PC). Et pour les entreprises, la perspective de ne pas remplacer des combinés téléphoniques vieillissants et coûteux.

Un développement à marche forcée

Reste la question des fonctionnalités. Et c’est là que la puissance de Microsoft évoquée en introduction a fait toute la différence. Car si des arguments financiers ou liés à la praticité pouvaient peser dans l’équation, les clients n’auraient pas fait le pas en cas de perte des fonctions rendues jusqu’à maintenant fidèlement par leur bon vieux PABX. Transferts d’appel, files d’attente, message d’accueil, gestion des plages horaires, distribution des appels entrants : l’absence des ces caractéristiques auraient constitué un frein indéniable au passage sur Teams.

Microsoft a donc progressivement enrichi son outil. Quitte à dépasser la concurrence. En tout cas sur le strict plan du rapport prix/prestation. Un exemple ? Il est possible désormais de mettre en place un message d’accueil textuel qui sera lu par une synthèse vocale tout à fait convaincante. Et ceci sans aucun surcoût. Avec la possibilité de gérer soi-même ces messages tout comme la configuration complète du central ou des lignes associées aux utilisateurs, le client a repris le contrôle de sa téléphonie. Et tout ceci pour le prix d’une licence mensuelle.

A partir de cet instant, la partie était plus ou moins pliée. La combinaison de coûts faibles, de fonctions avancées et d’une flexibilité extrême a amené les clients à avancer sur ce qui était désormais un terrain connu. Et à délaisser progressivement leur infrastructure téléphonique, qu’elle soit standard ou virtuelle. Microsoft, qui avait planté les graines de ce succès quelques années auparavant, n’avait désormais plus qu’à récolter les fruits de sa patience.

Emmanuel Dardaine

Et vous, êtes-vous prêt à passer sur Teams pour votre téléphonie d’entreprise ? Demandez-nous une démo pour finir de vous convaincre !